通过分析一个垃圾站坚定做日志分析的信心

下面就写一下自己如何分析一个垃圾站的过程,来坚定下大家做日志分析的信心。

起因:前段时间做了个垃圾站来玩玩,做好之后又失去了激情,就在那里放着了,提交了百度、谷歌,没有做过外链,只是最近几天随手发了几个垃圾帖子,算作外链吧。因为时间兴趣等原因,只是偶尔下载日志来看一下,没有做数据记录,没有仔细的观察。

经过:一直以来百度只是收录了首页,谷歌收录还不错但是没有排名没有流量。前天突然兴起想要把这站整一下,就去查看了一下日志,发现不论百度还是谷歌蜘蛛来的次数很少,抓取也是少得可怜。

结论:仔细分析了下,发现原来已经在很多地方体现了现在的恶劣后果。

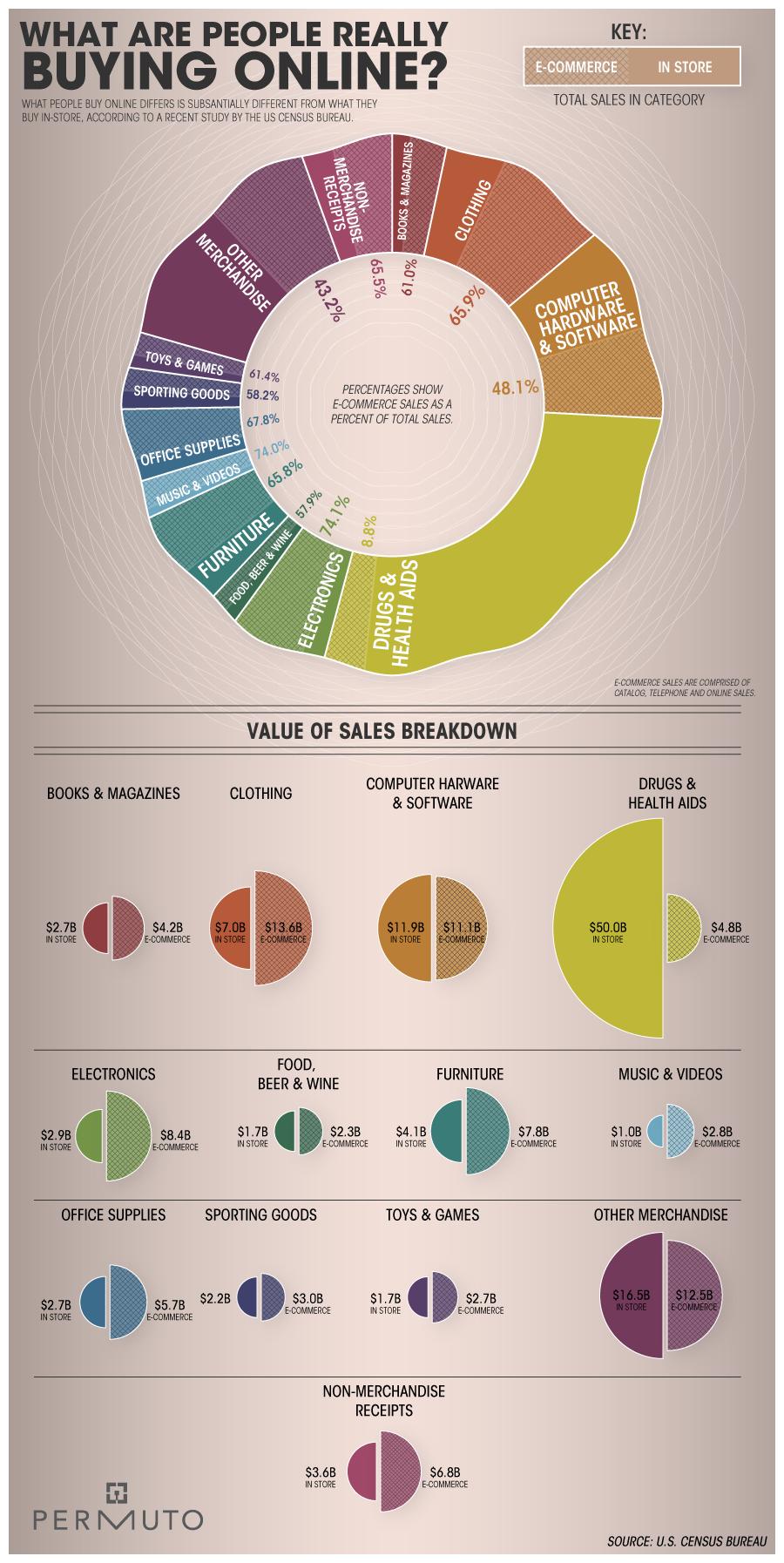

1.蜘蛛来的次数很少,虽然网站没有做外链,但是对于一个架构合理的网站(已经提交搜索引擎抓取)来说,一个月的时间已经能够积累一定权重让很多蜘蛛来主动抓取了(看抓取次数)。

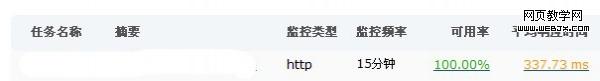

2.抓取数量很少,抓取数量=总抓取时间/每个页面加载时间,根据日志查看的总抓取时间和监控宝监控的网页加载时间,数据严重不相符(对比上图的总停留时间、总抓取量和下图的响应时间,悲剧的被遮住了重要数据,是337ms)。

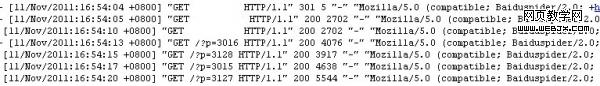

3.再看日志源文件,蜘蛛的抓取应该是快速密集的,通过数据提取明显有很大的问题(注意蜘蛛两次抓取时间间隔,应该是密集的,这是网站改动后还算正常的截图,之前的一塌糊涂)。

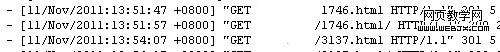

4.仔细观察就会发现日志中路径的抓取错误和返回码的错误(注意状态码,蜘蛛居然主动给后边加了/,抓取1746.html/ 才是返回200)。

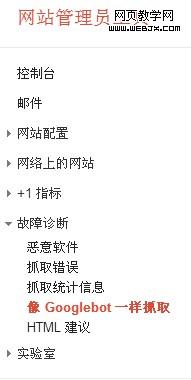

5.谷歌网站管理员工具的应用,有一个功能:像Googlebot一样抓取。在这里可以测试一个网页是否能被谷歌抓取成功和网页的返回状态码,自己之前只是测试了首页,这次测试了下内页居然返回的是301。

6.结论:空间商的伪静态规则有问题造成了网站的伪静态出现返回301的错误。

事后感想:我也不知道有什么感想,总之很乱。这些错误是很容易发现的,只是由于自己的疏忽或者是懒惰吧。

再一次证明日志分析,数据分析的强大!!