做SEO优化需要注意的细节

一个站长在做网站SEO优化的时候,难免会碰到关键词排名上不去,百度GG不收录等各种问题,那么我们可能就需要从自身优化的手段去寻找原因,下面我们就总结了一些容易影响网站排名,搜索收录的几点原因:

1.在关键字的选择上不够合理

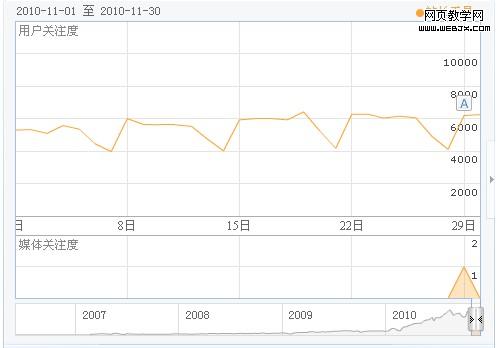

我们都知道,选取好了一个合理的关键,那么网站就成功了一半,那么我们如何来选择合理的关键词,当然最好的工具就是利用百度和GOOGLE竞价关键词工具来选取,然后在根据指数参考来确定关键字,比如,在百度,我们可以通过index.baidu.com来查询各个关键字的指数,需要注意的是,我们尽量选取那些在一年内的指数图是平滑的,那不要去选取那些突上突下的,那些很有可能就是被人家恶意刷的关键字,比如下图所示的站长工具就是一个不错的可以挖掘的关键字。

2.选取了错误的网页跳转方式

在选择网页跳转的方式上请使用301跳转,绝对不要使用JS跳转或者302跳转,蜘蛛是不可能识别你的JS跳转,反而容易认为你是一个作弊的网站,可能就把一个网站毁掉了。

3.过度的增加垃圾外链

做SEO优化的人都知道,外链是搜索的一个重要指标,但是如果你如果是成批成批的发布链接外链的话,也许在短期你的排名会有所上升,但是重长期来讲,你的站绝对会被K掉。所以我们只需要每天按规律发布一些外链,长久执行才是成功的而关键,欲速则不达。

4.不要使用JS导航或者flash导航菜单

我们都知道搜索是不会爬行JS代码和FLASH代码的,那么导航作为一个最重要的站内链接搜索找不到的话,会是一个非常大的损失,没有导航的网站,搜索可能把它判定为一个垃圾站,所有我们要避免使用JS和Flash来做导航,而应该使用html和css来设计我们的导航栏。

5.过度采集和复制相同文章

我们都知道搜索最看重的就是原创,一篇原创文章可能比你转载100篇文章的权重还要高,如果你的文章全部为采集或者复制过来的,相信搜索对你网站的好感度会相当低,建议大家如何一个标题在搜索引擎中能找出超过20篇相同的文章,你就不要再去转载了,基本上没有意义,我们要知道,搜索对你的友好度你比的都重要。

6.一定要正确的使用Robots.txt

关于如何编写正确的robots.txt,建议大家使用谷歌的网站管理员工具编写,这样才是最规范的,一个错误的语法可能导致搜索引擎屏蔽你的网站。

当然,对于一个网站的优化还有方方面面的细节需要注意,但是我们一定要把最基本做好,才能有一个好的排名。希望本文对站长能有所帮助。原创文章,转载请注明出自站长学院(www.pigzz.com)